Met LM Studio kunt u lokale AI-modellen (LLMs) draaien op uw eigen computer, zonder cloud-services zoals OpenAI. In deze gids leert u hoe u LM Studio installeert, een LLM downloadt, test, en hoe u de API-server opstart om het model in uw eigen applicaties te gebruiken.

1. LM Studio downloaden en installeren

LM Studio wordt geleverd als een AppImage, een zelfstandig uitvoerbaar bestand. Volg deze stappen om het te installeren:

- Download LM Studio

- Ga naar lmstudio.ai en download de Linux AppImage.

- Bewaar het bestand in een map zoals

~/Applications/.

- Maak het bestand uitvoerbaar

Open een terminal en voer het volgende commando uit:chmod +x ~/Applications/LM-Studio-*.AppImage - Start LM Studio

~/Applications/LM-Studio-*.AppImage. U kunt LM Studio nu gebruiken, maar laten we ervoor zorgen dat het ook in uw applicatiemenu staat.

2. LM Studio toevoegen aan het applicatiemenu

Maak een .desktop-bestand zodat LM Studio in uw menu verschijnt:

nano ~/.local/share/applications/LM-Studio.desktop

Plak deze inhoud en pas het pad aan:

[Desktop Entry]

Type=Application

Name=LM Studio

Exec=/home/user/Applications/LM-Studio-0.3.8-4-x64.AppImage --no-sandbox

Icon=/home/user/Applications/lmstudio-icon.png

Terminal=false

Categories=Development;AI;

Sla op met CTRL+O, sluit met CTRL+X, en update het menu:

update-desktop-database ~/.local/share/applications

Nu kunt u LM Studio openen vanuit het menu! 🎉

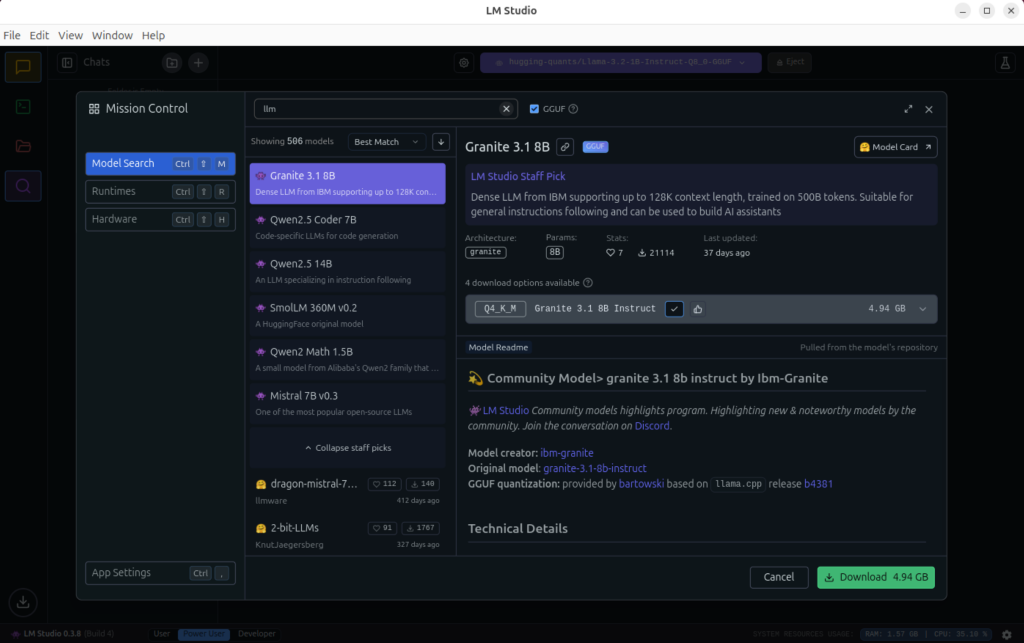

3. Een lokaal LLM-model downloaden

- Open LM Studio en ga naar Model Search.

- Zoek bijvoorbeeld Llama 3.2 1B Instruct (lichtgewicht en goed voor beginners).

- Selecteer een Q4_K_M of Q8_0 kwantisatie (hoe lager de bitwaarde, hoe minder RAM-verbruik).

- Wacht tot de download is voltooid.

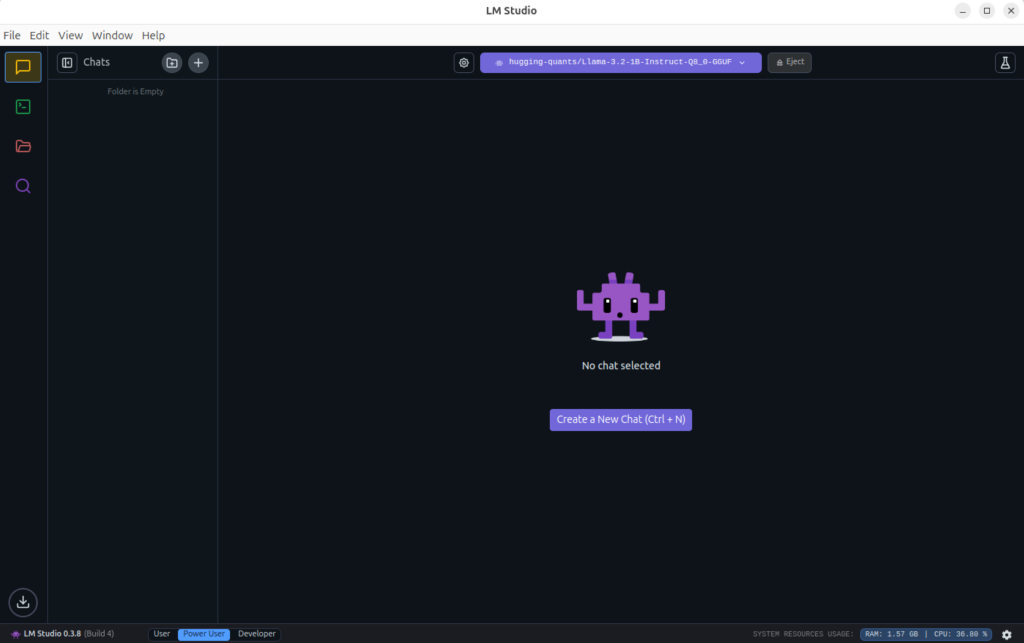

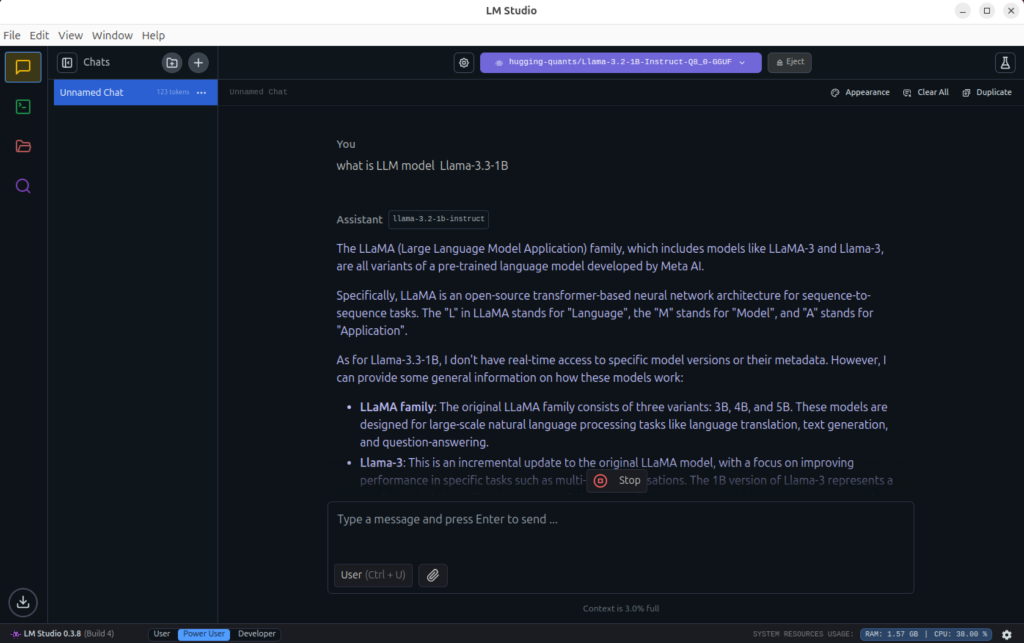

4. Testen of het model werkt

- Ga naar Chats in LM Studio.

- Kies een nieuw gesprek en selecteer het geladen model.

- Typ vragen zoals:

"Wat is de hoofdstad van Frankrijk?" "Leg kwantummechanica uit in simpele taal." "Wat is LLM model Llama-3.3-1B?" - Als het model antwoordt, werkt alles!

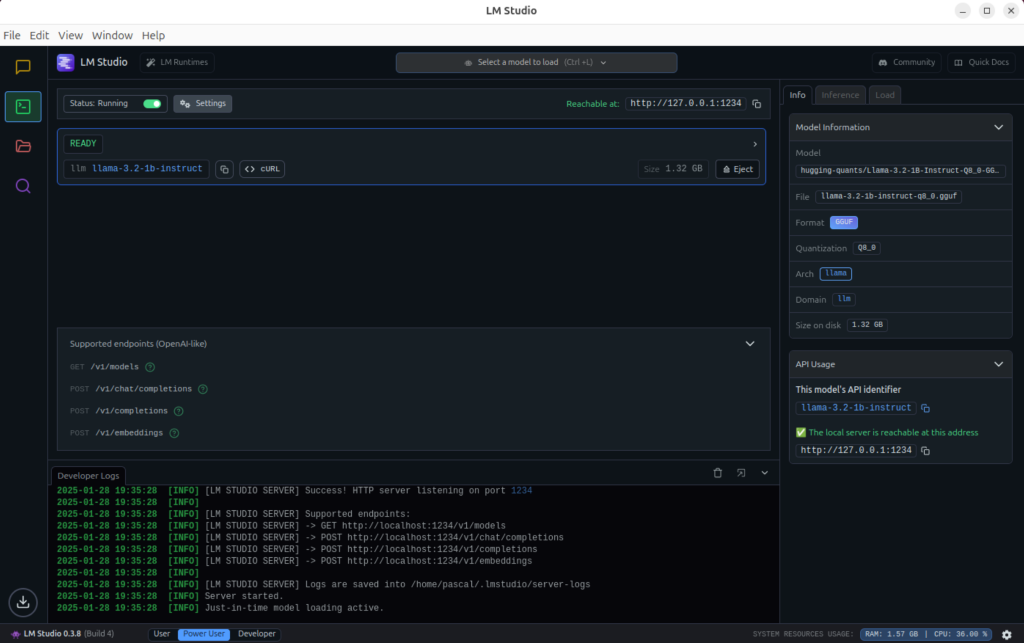

5. De LLM API-server starten voor gebruik in uw eigen app

Wilt u LM Studio integreren in uw eigen Python-app of chatbot? Start dan de lokale server:

- Open LM Studio en zet "Developer mode" aan.

- Klik op "Start Server" (de server draait dan op

http://127.0.0.1:1234). - Test of het werkt:

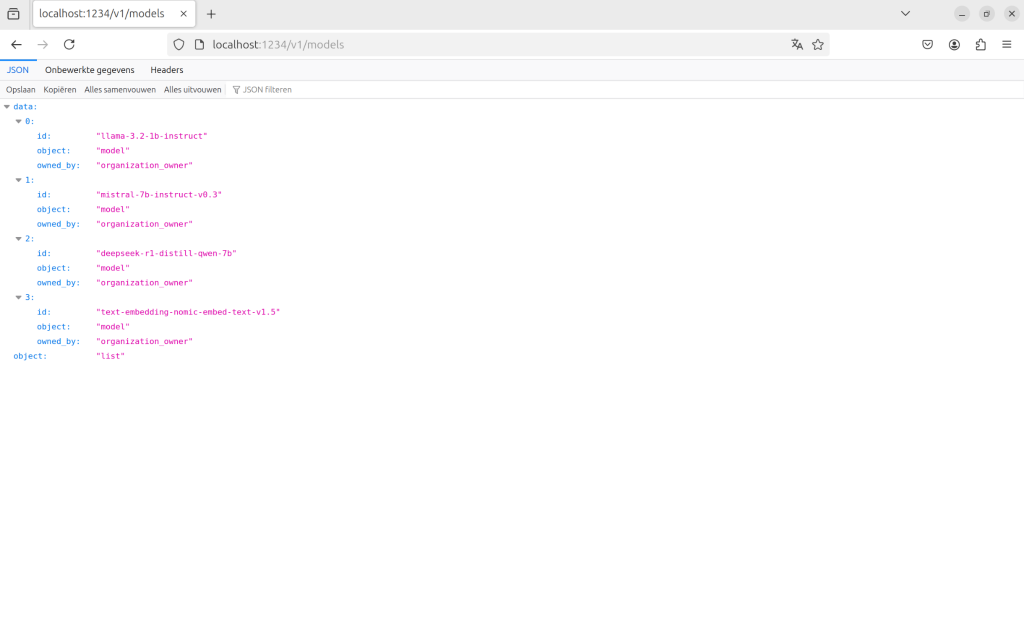

curl http://127.0.0.1:1234/v1/models

6. Voorbeeld: LLM gebruiken in een Python-app

Hier is een voorbeeld van hoe u een API-aanroep doet naar uw lokale LLM:

import requests

url = "http://127.0.0.1:1234/v1/chat/completions"

headers = {"Content-Type": "application/json"}

data = {

"model": "llama-3.2-1b-instruct",

"messages": [{"role": "user", "content": "Wat is de hoofdstad van Frankrijk?"}]

}

response = requests.post(url, json=data, headers=headers)

print(response.json())

Om een JSON-geformatteerd POST-verzoek in PHP te verzenden om te communiceren met de API van LM Studio, kunt u de cURL-bibliotheek van PHP gebruiken. Hier is hoe u de code kunt structureren:

<?php

// API endpoint URL

$url = 'http://127.0.0.1:1234/v1/chat/completions';

// Data to be sent in the POST request

$data = [

'model' => 'llama-3.2-1b-instruct',

'messages' => [

['role' => 'user', 'content' => 'Wat is de hoofdstad van Frankrijk?']

]

];

// Initialize cURL session

$ch = curl_init($url);

// Encode data to JSON format

$payload = json_encode($data);

// Set cURL options

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

curl_setopt($ch, CURLOPT_POST, true);

curl_setopt($ch, CURLOPT_POSTFIELDS, $payload);

curl_setopt($ch, CURLOPT_HTTPHEADER, [

'Content-Type: application/json',

'Content-Length: ' . strlen($payload)

]);

// Execute cURL request

$response = curl_exec($ch);

// Check for errors

if ($response === false) {

$error = curl_error($ch);

curl_close($ch);

die('cURL Error: ' . $error);

}

// Close cURL session

curl_close($ch);

// Decode and display the response

$result = json_decode($response, true);

print_r($result);

?>

Dit stuurt een vraag naar het lokale LLM en print het antwoord.

7. Minimum systeemvereisten voor LM Studio

Wilt u een lokale LLM draaien? Dit zijn de minimale en aanbevolen specificaties:

| Onderdeel | Minimale specs | Aanbevolen specs |

|---|---|---|

| CPU | Intel Core i5 (AVX2) | Intel i7/i9 of AMD Ryzen 7/9 |

| RAM | 8 GB | 16-32 GB (voor grotere modellen) |

| Opslag | 10 GB vrije ruimte | 50 GB+ (voor meerdere modellen) |

| GPU | Niet vereist | NVIDIA GPU met CUDA voor snellere prestaties |

Hoe krachtiger uw CPU/GPU, hoe sneller de LLM zal reageren. Een GPU zoals een NVIDIA RTX 3060+ kan het proces flink versnellen.

Conclusie

Met LM Studio kunt u lokale AI-modellen draaien, testen en gebruiken zonder afhankelijk te zijn van cloud-diensten. Of u nu een chatbot, AI-assistent of embedded LLM wilt maken, dit is een geweldige manier om AI lokaal te draaien. 🚀

De Angst voor AI in Softwareontwikkeling: Risico’s van Codeverspreiding en Privacyverlies

De Angst voor AI in Softwareontwikkeling: Risico’s van Codeverspreiding en Privacyverlies Draai een Large Language Model (LLM) lokaal met Ollama

Draai een Large Language Model (LLM) lokaal met Ollama Ontdek ComfyUI: de modulaire visuele AI-engine voor creatieve workflows

Ontdek ComfyUI: de modulaire visuele AI-engine voor creatieve workflows